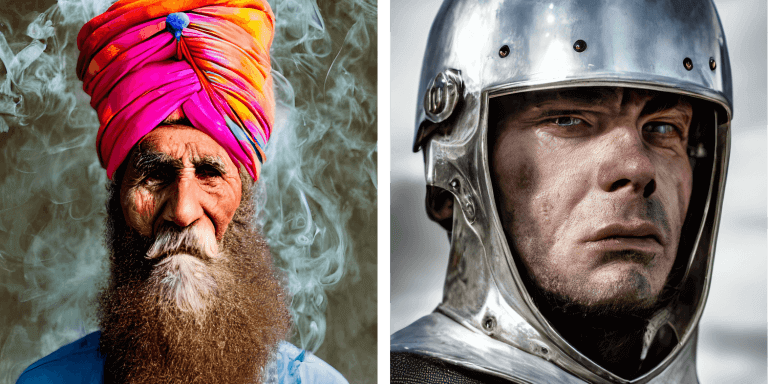

Representações artísticas espetaculares podem ser geradas em segundos a partir de descrições textuais

Estamos vivenciando uma evolução fascinante nas capacidades de Inteligência Artificial: a possibilidade de gerar imagens espetaculares com base em descrições textuais simples. Será uma total guinada na maneira com qual as pessoas produzem arte? É o que este artigo quer discutir a partir de agora.

Poucas palavras podem virar arte

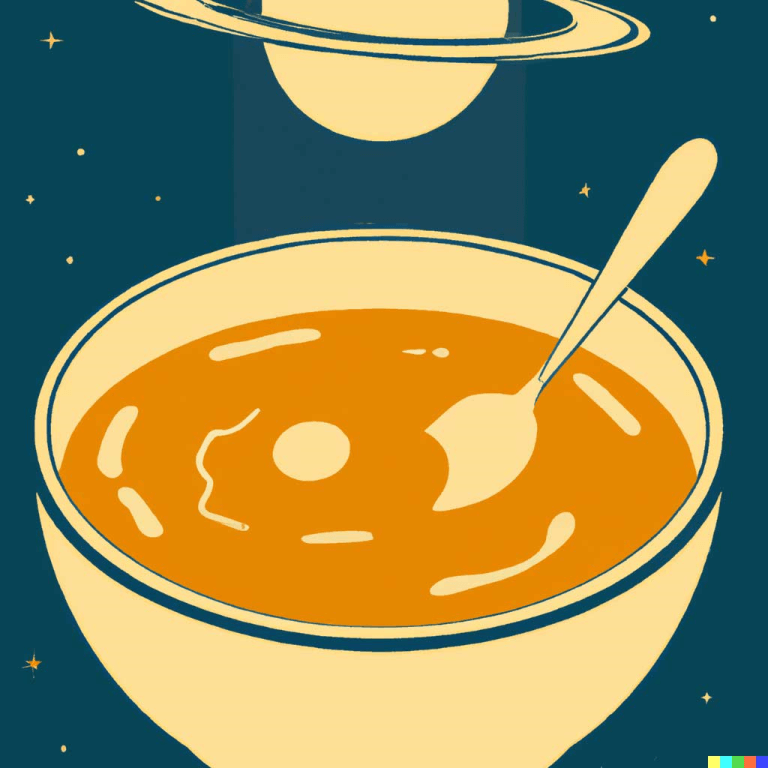

Uma tigela de sopa como um planeta no universo estilizado como um pôster da década de 1960. Uma frase desconexa, aparentemente. Porém, em um mundo onde avanços tecnológicos surgem e evoluem em velocidades impressionantes, uma frase como esta pode resultar em arte no mesmo tempo que você levou para repetir tais palavras.

Isto é possível graças à nova menina dos olhos da área da Inteligência Artificial: a criação de imagens, realísticas ou artísticas e inéditas, a partir de frases as quais podemos proferir com naturalidade. Uma tigela de sopa como um planeta no universo estilizado como um pôster da década de 1960, por exemplo. O resultado, criação do sistema DALL-E 2, você pode conferir abaixo.

O DALL-E 2

Em inglês, DALL-E soa igualzinho ao nome de um artista famoso, tanto pelas suas obras como pelo seu bigode: ele mesmo, Salvador Dalí i Domènech, 1º Marquês de Dalí de Púbol. Dalí, para todos que conhecem a sua arte.

O DALL-E 2 é criação da empresa de pesquisa e desenvolvimento OpenAI, que tem como missão declarada “garantir que a inteligência geral artificial beneficie toda a humanidade”. Por “inteligência geral artificial”, entenda-se “sistemas altamente autônomos que superam os humanos no trabalho economicamente mais valioso”, nas palavras da companhia, que tem a Microsoft como um de seus investidores.

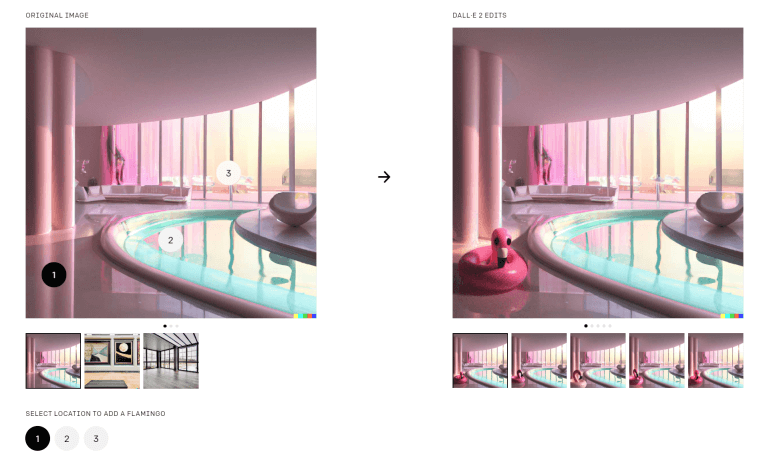

A primeira geração, o DALL-E, foi apresentada em janeiro de 2021. A segunda geração, revelada um ano depois, é aprimorada, com maior resolução, melhor compreensão e novas capacidades. Não somente criar imagens, as capacidades do DALL-E 2 incluem editar obras já existentes. Por exemplo, mudar ou expandir o fundo e adicionar ou remover elementos – sempre levando em consideração detalhes como sombras, reflexos e texturas.

O DALL-E 2 sabe estabelecer relações entre objetos individuais. Explicando: além de saber identificar a imagem de um coala e a imagem de uma motocicleta, ele sabe como relacionar os dois e assim posicionar um coala em cima de uma motocicleta. É desta maneira que a tecnologia pode entender quando alguém, por ventura, descreve em palavras um coala pilotando uma motocicleta.

Os criadores do DALL-E 2 apontam três principais resultados positivo da tecnologia. O primeiro é seu ineditismo, já que ela libera a criatividade das pessoas a um nível que não havia sido observado até agora.

O segundo é o maior entendimento que podemos ter sobre inteligência artificial e aprendizado de máquina a partir das imagens geradas. Quer dizer, ao descrevermos uma imagem e observarmos os resultados, podemos analisar se o sistema realmente compreende o que lhe é dito ou se ele apenas reproduz o que lhe foi ensinado.

O exemplo dado pelos criadores do DALL-E 2 é a expressão tree bark, que significa “casca de árvore”. Porém, a palavra bark, por si só, significa “latido”. Logo, espera-se que o DALLE-2, ao receber a descrição tree bark, reproduza a imagem de uma casca de árvore, não um cachorro latindo para uma árvore, por exemplo.

O terceiro resultado positivo do DALL-E 2 é que ele ajuda os humanos a compreenderem como sistemas de inteligência artificial veem e compreendem nosso mundo, o que é essencial para que tais sistemas sejam seguros.

O DALL-E 2, assim como todos os sistemas de IA, são como estudantes: eles aprendem a partir das informações que lhes são fornecidas. Se uma criança é ensinada que a palavra “carro” corresponde à imagem de um avião, ela vai estabelecer a relação errada entre as duas. O mesmo pode acontecer com o DALL-E 2.

O sistema também tem limitações quanto a “pegadinhas” de um idioma. Por exemplo, o bugio é também conhecido como macaco-uivador, ou howler monkey, em inglês. Se o sistema não for ensinado corretamente que há uma espécie denominada macaco-uivador, ao receber a descrição textual howler monkey, a imagem criada não vai representar a espécie corretamente, mas sim vai representar uma espécie qualquer de macaco executando a ação de uivar.

O DALL-E 2 também tem limitações intencionais por parte da sua equipe de desenvolvimento. Por exemplo, conteúdo violento, de ódio ou adulto é limitado entre os dados de treinamento da plataforma. Dessa maneira, a capacidade que o sistema tem de gerar imagens assim é reduzida. Os filtros do sistema estão a postos para identificar expressões e imagem que violem tais políticas. O DALL-E 2 também não é capaz de gerar rostos de pessoas reais – algo importante em tempos de deepfake, quer dizer, vídeos com os quais pessoas reais aparentemente estão falando algo, no entanto, o conteúdo é manipulado, literalmente colocando palavras na boca da pessoa sem que ela realmente as tenha proferido.

Atualmente, o DALL-E se encontra em estágio beta desde julho de 2022, para um número maior de pessoas em comparação com o seu lançamento. A plataforma funciona gratuitamente, porém com limitação no número de imagens que podem ser feitas gratuitamente. Ela pode ser acessada neste link.

O Stable Diffusion

Stable Diffusion é o nome de outra iniciativa de geração de imagens a partir de descrições textuais. A empresa responsável é a Stability AI, focada em desenvolver modelos de IA para imagem, linguagem, áudio, vídeo, 3D e biologia.

Os responsáveis pelo Stable Diffusion destacam o caráter democrático da ferramenta, uma vez que ela não precisa do que mais de 10 GB de memória VRAM para gerar imagens de 512x512 pixels em poucos segundos.

O Stable Diffusion tem vários componentes. Um deles é responsável por entender a descrição textual. Quer dizer, cada palavra do texto é transformada em um token, uma espécie de número identificador gerado por um modelo transformador de linguagem. O número é enviado a outro componente, o Gerador de Imagens, que processa a informação para que se chegue a um resultado de alta qualidade. Esta informação é enviada para o Decodificador de Imagem, que a usa para produzir a arte final.

O resultado é exibido em segundos, mas tal agilidade esconde um complexo processo que ocorre passo a passo, sendo que cada passo vai adicionando informações relevantes para a construção do resultado final.

Um componente primordial aqui é o Criador de Informação de Imagem. Além dos tokens, este criador usa matrizes de informações visuais iniciais e aleatórias, os chamados latentes. Dentro do contexto desta tecnologia, os latentes são conjuntos de informações que geram ruídos visuais, nome que se dá a qualquer estímulo visual aleatório. Trata-se do pontapé inicial para a composição da imagem.

Cada processo ocorre em uma matriz que gera outra matriz, cada vez mais de acordo com a descrição textual que gerou este processo. A cada passo, a matriz ganha novas informações a partir dos materiais com os quais a tecnologia foi treinada, e os latentes vão se transformando em imagens detalhadas e de acordo com a descrição textual.

Em outras palavras, pense como um canal de TV sendo sintonizado. Em um primeiro momento, a imagem pode ser nada mais do que chuviscos. Porém, a cada passo, os chuviscos vão ganhando informações e se transformando em uma imagem nítida e detalhada.

O Stable Diffusion tem seu código-fonte disponibilizado. A licença também tem limitações de uso, como para cometer crimes, difamação, assédio, exploração indevida, dar aconselhamento médico, criar automaticamente obrigações legais, produzir provas legais etc. O usuário possui os direitos sobre as imagens geradas e é livre para usá-las comercialmente. Clique aqui para acessar a plataforma.

A Difusão

Resumidamente, difusão é o nome dado ao processo de interpretação de textos em imagens de alta qualidade. O ruído visual inicial e aleatório começa como nada além disso mesmo: um estímulo visual. Porém, a cada etapa de processamento, este ruído vai ganhando mais e mais informações até se tornar a imagem final detalhada e condizente com a descrição textual.

O preenchimento que leva o resultado final de um simples ruído até uma composição detalhada vai se basear no treinamento da tecnologia, em como ela foi abastecida com informações visuais e suas respectivas correspondências textuais.

Nos casos das duas plataformas em questão, ambas usam a tecnologia CLIP, composta por codificadores de imagem e texto e treinada com 400 milhões de imagens e suas respectivas descrições. Especificamente, o Stable Diffusion foi treinado com um banco de dados focado em gerar imagens esteticamente agradáveis, logo, as imagens produzidas com esta tecnologia tendem a ser esteticamente agradáveis.

A difusão é utilizada tanto pelo Stable Diffusion quanto pelo DALLE-2, além de outras tecnologias de interpretação textual em imagens. Mas o Stable Diffusion tem uma espécie de pulo do gato neste sentido: o processo de difusão acontece em uma versão compactada da imagem, o que acelera o processo.

Vídeos também

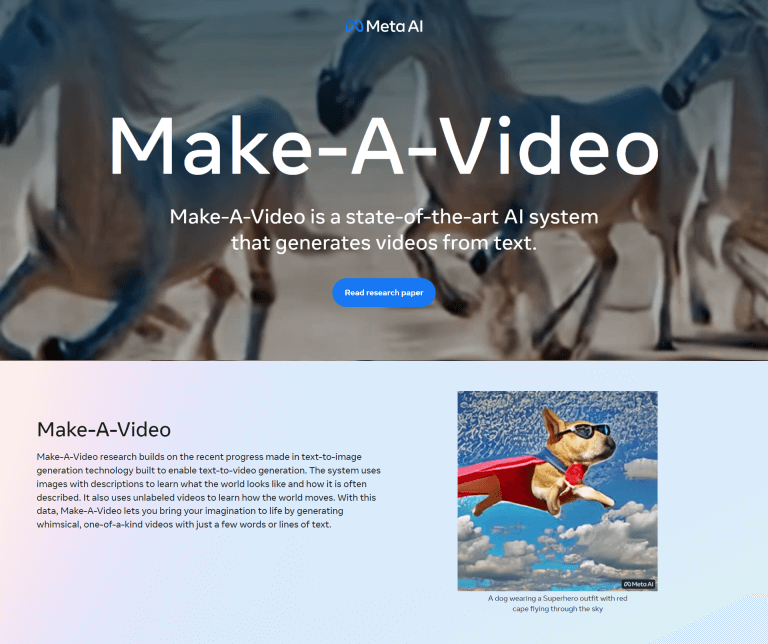

Acredite você: já existe tecnologia que cria vídeos a partir de descrições textuais, indo além da geração de imagens estáticas. Recentemente, a Meta, responsável por Facebook, Instagram e WhatsApp, entre outros empreendimentos tecnológicos, apresentou o Make-A-Video, um sistema de inteligência artificial que cria pequenos videoclipes a partir de textos. Trata-se de uma demonstração da capacidade criativa alcançada pela equipe de pesquisa da Meta, e a promessa é abrir novas oportunidades para criadores e artistas.

Segundo a Meta, “o sistema aprende como é o mundo a partir de dados de imagem de texto emparelhados e como o mundo se move a partir de imagens de vídeo sem texto associado. Com apenas algumas palavras ou linhas de texto, o Make-A-Video pode dar vida à imaginação e criar vídeos únicos cheios de cores vivas, personagens e paisagens. O sistema também pode criar vídeos a partir de imagens ou pegar vídeos existentes e criar novos semelhantes”.

A pesquisa sobre o Make-A-Video vai continuar, e a Meta promete ser transparente em relação aos resultados. Clique aqui para acessar a plataforma e saber mais.

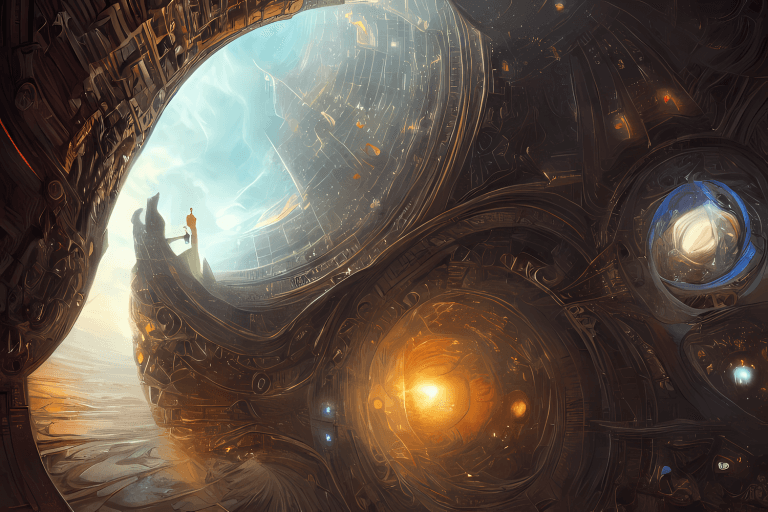

Tecnologia Visionária

Nós da Visionnaire somos fissurados por tecnologias incipientes e promissoras como a geração de imagens a partir de descrições textuais. É com muita empolgação que estamos vivenciando mais uma revolução proporcionada pela Inteligência Artificial e pelo Aprendizado de Máquina.

Fazemos parte de uma das indústrias mais dinâmicas do mundo, se não a mais dinâmica, que é o desenvolvimento de softwares, que se renova a cada dia com novidades fascinantes como a criação de imagens inéditas e detalhadas em segundos.

Temos como missão a constante renovação na nossa maneira de desenvolver softwares, com novas perspectivas em soluções e em modelo de negócio. E certamente já pensamos em maneiras de como fazer bom uso de ferramentas como Stable Diffusion e DALLE-2. Afinal, ser visionário não está somente em nosso nome, mas é também nossa essência.

Certamente, podemos estar diante de uma total transformação na maneira como arte é produzida. Neste momento, como toda tecnologia incipiente, a transformação de textos em imagens está começando a se democratizar. Isto quer dizer que ainda não se trata de uma tecnologia disponível para massas. Neste sentido, o Stable Diffusion tem papel importante, visto que é mais acessível do que a concorrência.

Outra característica importante de tecnologias incipientes é seu uso ético e moral. Tanto Stable Diffusion como DALLE-2 tomam medidas para que as tecnologias não sejam usadas de maneira prejudicial. E o nível de controle sobre a segurança de uma tecnologia nova também é algo que determina seu sucesso ou fracasso.

Também como acontece com qualquer tecnologia incipiente, há uma mistura de reações. Os mais puristas não vão considerar as imagens prontas como arte; já os mais vanguardistas não pensarão duas vezes para incorporar as tecnologias à sua maneira de criação artísticas.

O debate está aberto. Desde questões sobre o que é arte (se é que se pode defini-la) até dúvidas sobre como a tecnologia vem impactando a produção de arte. Tecnologias recentes como blockchain e NFT certamente já mudaram a maneira como a arte é difundida e comercializada. Agora, paradigmas sobre a produção de arte podem estar prestes a mudar para sempre.