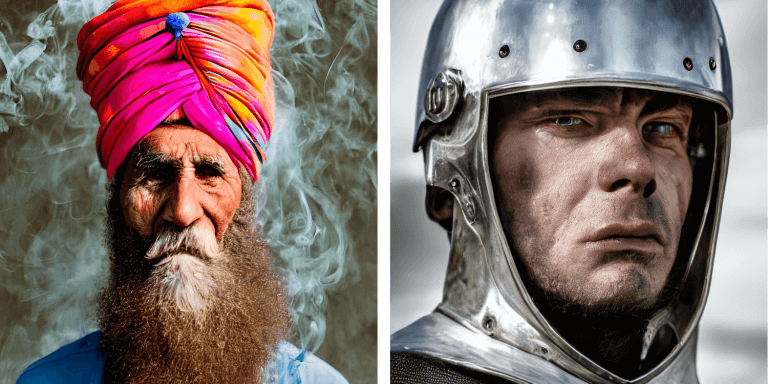

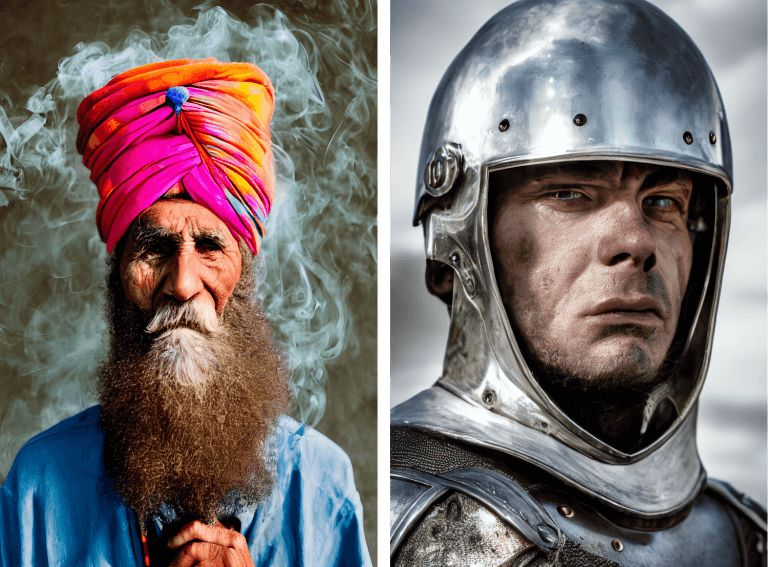

Se pueden generar representaciones espectaculares en segundos a partir de descripciones textuales

Estamos experimentando una evolución fascinante en las capacidades de la Inteligencia Artificial: la posibilidad de generar imágenes espectaculares basadas en descripciones textuales simples. ¿Será un cambio total en la forma en que la gente hace arte? Eso es lo que este artículo quiere discutir a partir de ahora.

Pocas palabras pueden convertirse en arte

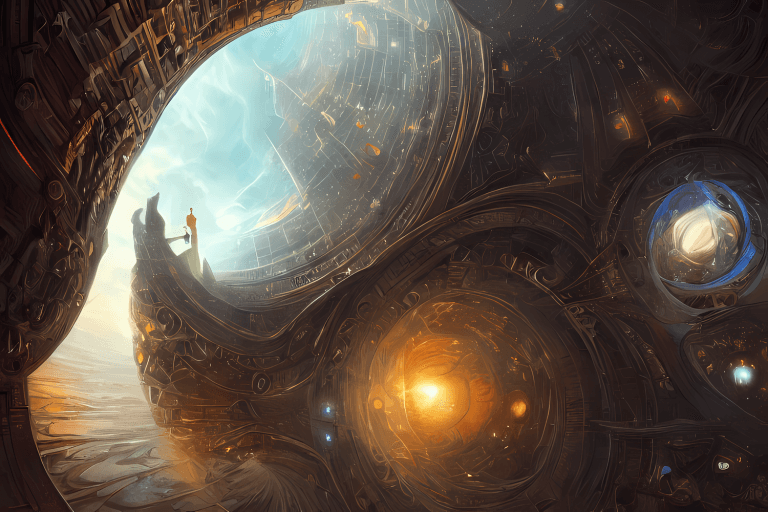

Un plato de sopa como un planeta en el universo estilizado como un póster de los años 1960. Una frase inconexa, aparentemente. Sin embargo, en un mundo donde los avances tecnológicos surgen y evolucionan a velocidades impresionantes, una frase como esta puede convertirse en arte en el mismo tiempo que te tomó repetir esas palabras.

Esto es posible gracias a un avance impresionante en el área de la Inteligencia Artificial: la creación de imágenes, realistas o artísticas e inéditas, a partir de frases que podemos pronunciar con naturalidad. Un plato de sopa como un planeta en el universo estilizado como un póster de los años 1960, por ejemplo. El resultado, la creación del sistema DALL-E 2, se puede ver a continuación.

EL DALL-E 2

DALL-E suena como el nombre de un artista famoso, tanto por sus obras como por su bigote: él mismo, Salvador Dalí i Domènech, 1er marqués de Dalí de Púbol. Dalí, para todos los que conocen su arte.

DALL-E 2 es una creación de la empresa de investigación y desarrollo OpenAI, cuya misión declarada es "garantizar que la inteligencia artificial general beneficie a toda la humanidad". Por “inteligencia general artificial” se refieren a “sistemas altamente autónomos que superan a los humanos en el trabajo económicamente más valioso”, en palabras de la compañía, que tiene a Microsoft como uno de sus inversores.

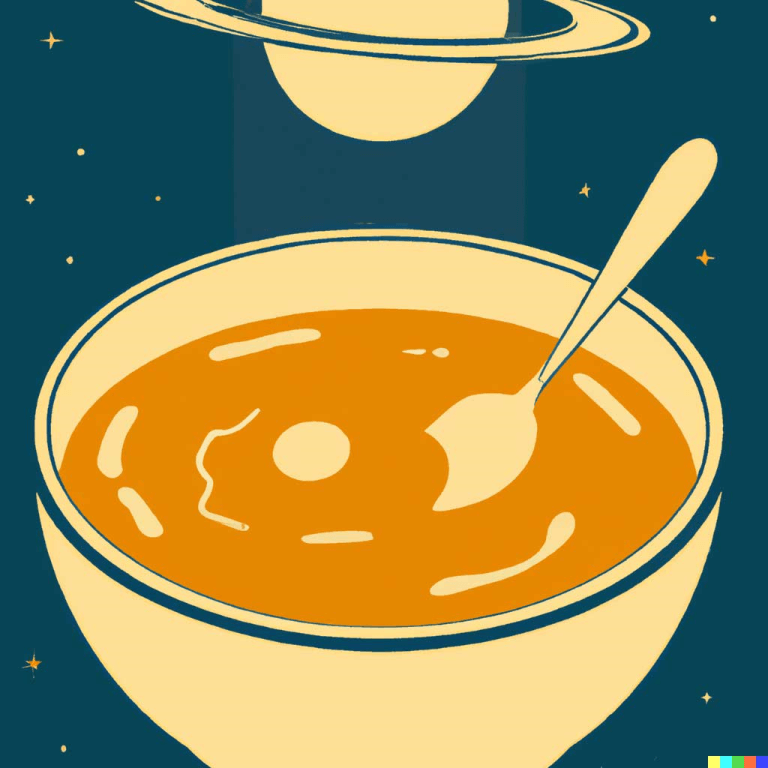

La primera generación, DALL-E, se presentó en enero de 2021. La segunda generación, revelada un año después, está mejorada, con mayor resolución, mejor comprensión y nuevas capacidades. No solo crea imágenes, las capacidades de DALL-E 2 incluyen la edición de obras existentes. Por ejemplo, cambiar o ampliar el fondo y añadir o quitar elementos, siempre teniendo en cuenta detalles como sombras, reflejos y texturas.

DALL-E 2 sabe cómo establecer relaciones entre elementos individuales. Explicando: además de saber identificar la imagen de un koala y la imagen de una moto, sabe relacionar las dos y así posicionar un koala encima de una moto. Así es como la tecnología puede entender cuando alguien describe con palabras a un koala pilotando una moto.

Los creadores de DALL-E 2 señalan tres resultados positivos principales de la tecnología. El primero es su originalidad, ya que da rienda suelta a la creatividad de las personas a un nivel que no se había observado hasta ahora.

La segunda es la mayor comprensión que podemos tener sobre la inteligencia artificial y el aprendizaje automático a partir de las imágenes generadas. Es decir, describiendo una imagen y observando los resultados, podemos analizar si el sistema realmente entiende lo que se le dice o si simplemente reproduce lo que se le enseña.

El ejemplo dado por los creadores del DALL-E 2 es la expresión tree bark, que significa “corteza de árbol”. Sin embargo, la palabra bark, por sí sola, significa “ladrar”. Por lo tanto, se espera que DALLE-2, al recibir la descripción tree bark, reproduzca la imagen de la corteza de un árbol, no la de un perro ladrando a un árbol, por ejemplo.

El tercer resultado positivo de DALL-E 2 es que ayuda a los humanos a comprender cómo los sistemas de inteligencia artificial ven y entienden nuestro mundo, lo cual es esencial para que dichos sistemas sean seguros.

DALL-E 2, como todos los sistemas de IA, es como los estudiantes: aprenden de la información que se les da. Si a un niño se le enseña que la palabra coche corresponde a la imagen de un avión, establecerá la relación equivocada entre ambos. Lo mismo puede pasar con el DALL-E 2.

El sistema también tiene limitaciones cuanto el idioma. Por ejemplo, el mono aullador. Si al sistema no se le enseña correctamente que existe una especie llamada aullador, al recibir la descripción textual mono aullador, la imagen creada no representará correctamente a la especie, sino que representará a cualquier especie de mono realizando la acción de aullido.

DALL-E 2 también tiene limitaciones intencionales por parte de su equipo de desarrollo. Por ejemplo, el contenido violento, de odio o para adultos está limitado entre los datos de entrenamiento de la plataforma. De esta forma, se reduce la capacidad del sistema para generar dichas imágenes. Existen filtros del sistema para identificar expresiones e imágenes que violan estas políticas. El DALL-E 2 tampoco es capaz de generar caras de personas reales, algo importante en tiempos de deepfake, es decir, videos con personas reales aparentemente hablando de algo, sin embargo, se manipula el contenido, literalmente poniendo palabras en la boca de la persona sin que él realmente las haya dicho.

Actualmente, DALL-E está en etapa beta desde julio de 2022, a un mayor número de personas en comparación con su lanzamiento. La plataforma funciona de forma gratuita, pero con una limitación en la cantidad de imágenes que se pueden hacer. Se puede acceder en este enlace.

El Stable Diffusion

Stable Diffusion es el nombre de otra iniciativa de generación de imágenes a partir de descripciones textuales. La empresa responsable es Stability AI, enfocada en desarrollar modelos de IA para imagen, lenguaje, audio, video, 3D y biología.

Los responsables de Stable Diffusion destacan el carácter democrático de la herramienta, ya que no necesita más de 10 GB de memoria VRAM para generar imágenes de 512x512 píxeles en pocos segundos.

La difusión estable tiene varios componentes. Uno de ellos se encarga de comprender la descripción textual. Es decir, cada palabra del texto se transforma en un token, una especie de número identificador generado por un modelo de lenguaje transformador. El número se envía a otro componente, el Generador de Imágenes, que procesa la información para obtener un resultado de alta calidad. Esta información se envía al Decodificador de Imágenes, que la utiliza para producir la obra de arte final.

El resultado se muestra en segundos, pero esa agilidad esconde un proceso complejo que se desarrolla paso a paso, agregando cada paso información relevante para la construcción del resultado final.

Un componente clave aquí es el Creador de Información de Imagen. Además de tokens, este creador utiliza matrices de información visual inicial y aleatoria, las llamadas latentes. En el contexto de esta tecnología, las latentes son conjuntos de información que generan ruido visual, nombre que se le da a cualquier estímulo visual aleatorio. Este es el punto de partida para la composición de la imagen.

Cada proceso tiene lugar en una matriz que genera otra matriz, cada vez más de acuerdo con la descripción textual que generó este proceso. En cada paso, la matriz obtiene nueva información de los materiales con los que se entrenó la tecnología, y las latentes se transforman en imágenes detalladas y de acuerdo con la descripción textual.

En otras palabras, piense como un canal de televisión sintonizado. Al principio, la imagen puede no ser más que lloviznas. Sin embargo, a cada paso, las lloviznas ganan información y se transforman en una imagen clara y detallada.

Stable Diffusion tiene disponible su código fuente. La licencia también tiene limitaciones y no permite su uso para cometer delitos, difamación, acoso, explotación indebida, dar consejos médicos, crear automáticamente obligaciones legales, producir pruebas legales, etc. El usuario posee los derechos de las imágenes generadas y es libre de utilizarlas comercialmente. Haga clic aquí para acceder a la plataforma.

La Difusión

Brevemente, difusión es el nombre que se le da al proceso de interpretación de textos en imágenes de alta calidad. El ruido visual aleatorio inicial comienza como nada más que eso: un estímulo visual. Sin embargo, en cada paso del procesamiento, este ruido gana más y más información hasta convertirse en la imagen detallada final que es consistente con la descripción textual.

El relleno que lleve el resultado final de un simple ruido a una composición detallada se basará en el entrenamiento de la tecnología, en cómo se suministró la información visual y sus respectivas correspondencias textuales.

En los casos de las dos plataformas en cuestión, ambas utilizan tecnología CLIP, compuesta por codificadores de imagen y texto y entrenada con 400 millones de imágenes y sus respectivas descripciones. Específicamente, Stable Diffusion fue entrenado con una base de datos enfocada en generar imágenes estéticamente agradables, por lo que las imágenes producidas con esta tecnología tienden a ser estéticamente agradables.

Diffusion es utilizado tanto por Stable Diffusion como por DALLE-2, así como por otras tecnologías de interpretación textual en imágenes. Pero Stable Diffusion tiene algo diferente: el proceso de difusión tiene lugar en una versión comprimida de la imagen, lo que acelera el proceso.

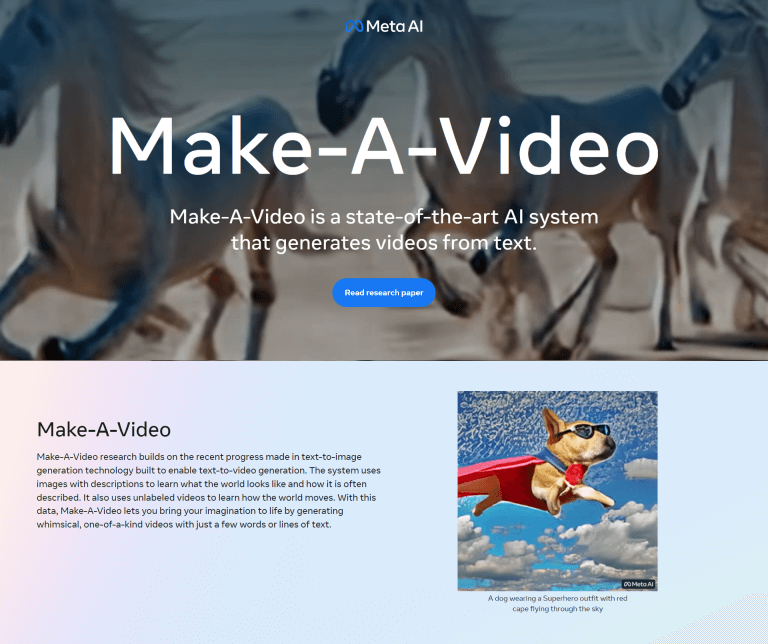

Vídeos también

Créanme: ya existe tecnología que crea videos a partir de descripciones textuales, yendo más allá de la generación de imágenes fijas. Recientemente, Meta, responsable de Facebook, Instagram y WhatsApp, entre otros emprendimientos tecnológicos, presentó Make-A-Video, un sistema de inteligencia artificial que crea videoclips cortos a partir de textos. Es una demostración de la capacidad creativa lograda por el equipo de investigación de Meta, y la promesa es abrir nuevas oportunidades para creadores y artistas.

Según Meta, “el sistema aprende cómo se ve el mundo a partir de datos de imágenes de texto emparejado y cómo se mueve el mundo a partir de imágenes de video sin texto asociado. Con solo unas pocas palabras o líneas de texto, Make-A-Video puede darle vida a su imaginación y crear videos únicos llenos de colores vivos, personajes y paisajes. El sistema también puede crear videos a partir de imágenes o tomar videos existentes y crear otros nuevos”.

La investigación sobre Make-A-Video continuará y Meta promete ser transparente sobre los resultados. Haga clic aquí para acceder a la plataforma y obtener más información.

Tecnología visionaria

En Visionnaire estamos obsesionados con tecnologías incipientes y prometedoras como la generación de imágenes a partir de descripciones textuales. Es con gran entusiasmo que estamos experimentando otra revolución proporcionada por la Inteligencia Artificial y el Aprendizaje Automático.

Formamos parte de una de las industrias más dinámicas del mundo, si no la más dinámica, que es la del desarrollo de software, que se renueva cada día con novedades fascinantes como la creación de imágenes inéditas y detalladas en segundos.

Nuestra misión es renovar constantemente nuestra forma de desarrollar software, con nuevas perspectivas de soluciones y modelo de negocio. Y ciertamente hemos pensado en formas de hacer un buen uso de herramientas como Stable Diffusion y DALLE-2. Después de todo, ser visionario no está solo en nuestro nombre, sino también en nuestra esencia.

Ciertamente, podemos estar ante una transformación total en la forma de producir arte. En este momento, como toda tecnología incipiente, la transformación de textos en imágenes empieza a democratizarse. Esto significa que aún no es una tecnología disponible para las masas. En este sentido, Stable Diffusion juega un papel importante, ya que es más accesible que la competencia.

Otra característica importante de las tecnologías incipientes es su uso ético y moral. Tanto Stable Diffusion como DALLE-2 toman medidas para garantizar que las tecnologías no se utilicen de manera dañina. Y el nivel de control sobre la seguridad de una nueva tecnología también es algo que determina su éxito o fracaso.

Además, como con cualquier tecnología incipiente, hay reacciones mixtas. Los más puristas no considerarán las imágenes confeccionadas como arte; los más vanguardistas no dudarán en incorporar tecnologías a su forma de creación artística.

El debate está abierto. Desde preguntas sobre qué es el arte (si se puede definir) hasta dudas sobre cómo ha impactado la tecnología en la producción de arte. Las tecnologías recientes como blockchain y NFT ciertamente han cambiado la forma en que se difunde y comercializa el arte. Ahora, los paradigmas sobre la producción de arte pueden estar a punto de cambiar para siempre.