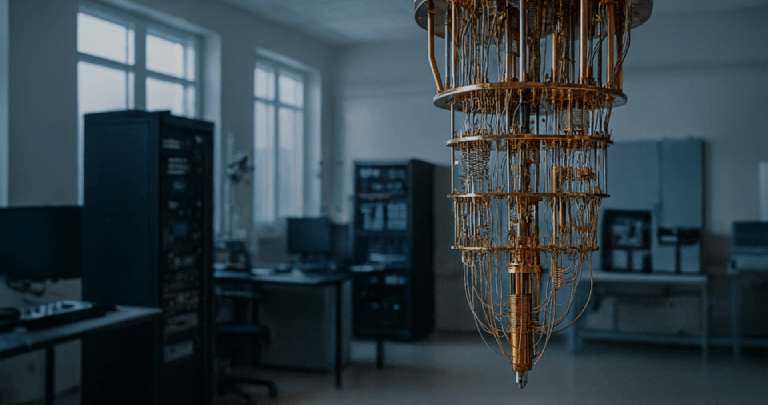

Del laboratorio al mercado, entienda por qué Google, IBM, Microsoft y NVIDIA están acelerando una revolución que impactará su negocio

En 1981, Richard Feynman se preguntó

por qué los investigadores intentaban simular la física cuántica en computadores clásicos si la

propia naturaleza es cuántica. A partir de esa visión nació la idea de construir computadores que utilizan

directamente las reglas de la mecánica cuántica para resolver problemas que, para las máquinas tradicionales,

serían imposibles o económicamente inviables.

Durante décadas, la Computación

Cuántica fue tema de congresos científicos, no de reuniones de directorio. Permaneció restringida a artículos

académicos, laboratorios y a un pequeño grupo de especialistas dispersos por el mundo. Se la veía como

algo “para dentro de muchas décadas”.

Demos un salto hasta hoy. En una de sus conferencias,

Jensen Huang, CEO de NVIDIA, hace un resumen directo: casi nadie hablaba de Computación Cuántica fuera del ámbito

académico; los resultados eran esencialmente experimentales. Ahora, el vocabulario ha cambiado. Entraron en escena

palabras como producto, plataforma, alianza e inversión. Los grandes actores (Google, IBM, Microsoft y la propia NVIDIA)

transformaron un campo de investigación en una carrera comercial. Cuando empresas de este tamaño alinean marca,

presupuesto y hoja de ruta en torno a la misma tecnología, el mensaje para el mercado es claro: ya no es ciencia ficción,

es una transición en marcha.

De la teoría a la práctica:

la evolución de la Computación Cuántica

Esta historia puede resumirse en algunos hitos.

En la década de 1980, Feynman plantó la semilla al proponer que sistemas cuánticos se utilizaran para

simular fenómenos cuánticos. En las décadas siguientes, los años 1990 y 2000, surgieron algoritmos

que mostraron el potencial de este modelo, como el algoritmo de Shor, capaz de factorizar números grandes de manera

mucho más eficiente que cualquier método clásico conocido, y el de Grover, que acelera búsquedas

en bases de datos. Todo seguía siendo teórico, pero ya había una enorme promesa implícita.

A partir de 2010, empezamos a ver los primeros

dispositivos accesibles. Las plataformas en la nube permitieron que investigadores y empresas experimentaran en hardware cuántico

real. IBM, por ejemplo, puso a disposición el acceso remoto a sus primeros computadores cuánticos, abriendo

la posibilidad de probar algoritmos y aplicaciones sin tener que montar un laboratorio completo.

Entre 2020 y 2025, la curva se vuelve más

pronunciada. Entramos en la fase en la que la Computación Cuántica deja de ser solo un “tema de trabajo”

y pasa a aparecer en presentaciones de producto, discursos a inversores y estrategias de largo plazo de las grandes tecnológicas.

Es el momento en que los qubits (bits cuánticos, es decir, la unidad básica de información en computación

cuántica) y los circuitos cuánticos empiezan a compartir espacio con KPIs, ROI y hojas de ruta tecnológicas.

El papel de los gigantes: Google, IBM, Microsoft

y NVIDIA

Google acaparó los focos cuando anunció

que su procesador cuántico Sycamore, con 53 qubits, ejecutó una tarea específica en cerca de 200 segundos,

algo que, según la propia empresa, le llevaría miles de años a un supercomputador clásico. El

término “supremacía cuántica” generó debate, pero una conclusión quedó

clara: ya existen problemas muy específicos en los que un computador cuántico supera a cualquier máquina

clásica conocida. Para el mundo corporativo, esto enciende simultáneamente dos señales: la de la oportunidad

(nuevas formas de simular, optimizar y analizar datos) y la del riesgo (quedarse atrás en capacidad de modelado e innovación).

IBM siguió un camino complementario,

tratando la Computación Cuántica como producto desde el inicio. Al anunciar procesadores con más de 1.000

qubits, como Condor, la empresa va más allá del número absoluto de qubits y presenta una hoja de ruta

pública, hablando abiertamente de supercomputadores “cuántico-céntricos” que combinan hardware

cuántico, software, servicios en la nube y casos de uso bien definidos. Finanzas, química, logística

y energía son algunos de los sectores ya mapeados en sus materiales y demostraciones. El mensaje es: existe un plan,

no solo un experimento de laboratorio.

Microsoft, por su parte, apuesta por los qubits

topológicos, un tipo de qubit diseñado para ser más resistente al ruido y, por tanto, más adecuado

para la escalabilidad. El anuncio de chips con “núcleos topológicos” y la visión de alcanzar

millones de qubits en un único chip revelan una ambición a largo plazo. Existe escepticismo en la comunidad

científica, y abundan las discusiones sobre hasta qué punto el marketing se adelanta a la realidad técnica.

Aun así, la inversión es concreta: expansión de laboratorios, alianzas con centros de investigación

e integración clara con el ecosistema Azure, preparando el entorno para cargas de trabajo cuánticas en cuanto

la tecnología esté lista para producción.

NVIDIA eligió una posición estratégica

diferente. En lugar de competir directamente por tener “el mayor computador cuántico”, la empresa quiere

ser el pegamento entre Computación Cuántica, IA y Computación de Alto Rendimiento. Con la plataforma

CUDA-Q, ofrece un entorno en el que el desarrollador puede orquestar CPUs, GPUs y QPUs en un mismo flujo de trabajo. En la

práctica, es posible escribir aplicaciones donde parte de la carga se ejecuta en GPU (simulación, IA, preprocesamiento)

y otra parte específica se envía a un procesador cuántico. Al sumar interconexiones especializadas y

alianzas con empresas cuánticas, NVIDIA se posiciona como la infraestructura estándar de un futuro híbrido,

en el que distintos tipos de procesadores trabajan juntos.

Lo que ya es posible hacer hoy con Computación

Cuántica

Si usted es un decisor de tecnología

o de negocio, es natural preguntarse qué se puede hacer en términos concretos ahora mismo. Es importante ser

honesto: la mayoría de los equipos actuales está en la fase NISQ (Noisy Intermediate-Scale Quantum),

lo que significa que cuentan con decenas o cientos de qubits todavía muy susceptibles al ruido. Aun así, ya

se están probando varias frentes de aplicación.

En el campo de la optimización, problemas

como el ruteo de flotas, la planificación de la producción y la asignación de recursos se estudian con

algoritmos cuánticos o inspirados en lo cuántico, a menudo combinados con técnicas de Inteligencia Artificial.

En química y ciencia de materiales, las simulaciones de moléculas complejas y estructuras avanzadas son candidatos

naturales para la ventaja cuántica, con impacto en la industria farmacéutica, energía, fertilizantes,

baterías y más. En el sector financiero, hay investigaciones en modelado de riesgo, valoración de derivados

y optimización de carteras utilizando enfoques híbridos. Y, más recientemente, empiezan a aparecer experimentos

en aprendizaje automático cuántico (Quantum Machine Learning, QML), que utilizan circuitos cuánticos

como bloques de construcción en modelos de IA.

En la práctica, la mayor parte de esto

aún se encuentra en la etapa de I+D: proyectos piloto, pruebas de concepto y colaboraciones entre empresas de tecnología,

universidades y actores de sectores estratégicos. El punto crucial es que las organizaciones que comienzan a experimentar

ahora ganan una reserva de conocimiento difícil de copiar más adelante.

Seguridad y criptografía en el mundo

poscuántico

Otro punto que preocupa a ejecutivos y equipos

de tecnología es la seguridad. Los algoritmos cuánticos, como el de Shor, tienen el potencial de romper esquemas

criptográficos ampliamente utilizados hoy, como RSA y ECC, siempre que existan computadores cuánticos grandes

y fiables. Esto hace que el debate sobre la seguridad poscuántica deje de ser teórico y se vuelva estratégico.

Organismos de estandarización como el

NIST (National Institute of Standards and Technology) ya seleccionaron algoritmos de criptografía poscuántica,

como CRYSTALS-Kyber para el intercambio de claves, y CRYSTALS-Dilithium, FALCON y SPHINCS+ para firmas digitales. Al mismo

tiempo, crece la preocupación con el escenario de “cosechar ahora, descifrar después”, en el que

datos cifrados hoy se almacenan para ser descifrados en el futuro, cuando la Computación Cuántica alcance la

madurez.

Si su organización gestiona información

sensible de larga duración (datos de salud, registros gubernamentales, propiedad intelectual, contratos de largo plazo,

secretos industriales), la migración a algoritmos poscuánticos no es un tema para dejar “para más

adelante”. Debe entrar en la hoja de ruta de seguridad ahora, junto con otras iniciativas de transformación digital.

Lo que esto significa para su empresa hoy

La buena noticia es que no necesita comprar

un computador cuántico mañana por la mañana. La mala noticia es que, si no se hace nada, existe el riesgo

de quedarse atrás precisamente cuando esta tecnología comience a ofrecer ventajas prácticas. El secreto

está en actuar en tres frentes: riesgo, oportunidad y preparación.

En primer lugar, es fundamental comprender el

horizonte de riesgo y oportunidad de su negocio. ¿Durante cuánto tiempo sus datos necesitan mantenerse confidenciales?

Si la respuesta se mide en décadas, la criptografía poscuántica entra inmediatamente en la conversación.

¿Su modelo de negocio depende de optimización compleja, simulaciones sofisticadas o detección de patrones?

En ese caso, la Computación Cuántica deja de ser solo una amenaza y pasa a ser una oportunidad concreta de ventaja

competitiva.

A continuación, vale la pena empezar

en pequeño, pero empezar. No es necesario ejecutar código en un computador cuántico físico; los

simuladores de alto rendimiento, muchas veces basados en GPU, ya permiten probar algoritmos, entender limitaciones, adaptar

equipos y mapear casos de uso relevantes. Un proyecto piloto bien definido, aunque modesto, suele generar más aprendizaje

real que años de acompañamiento distante del tema.

Por último, es esencial fortalecer la

base tecnológica. La Computación Cuántica no reemplazará los sistemas heredados de una sola vez;

se conectará a ellos. Esto exige datos bien gobernados, arquitecturas modernas orientadas a APIs, uso estratégico

de la nube y, sobre todo, madurez en Inteligencia Artificial. Las aplicaciones más prometedoras del futuro tienden

a ser híbridas, combinando IA, supercomputación y aceleradores cuánticos en un mismo flujo de trabajo.

Cómo Visionnaire puede apoyar su trayectoria

en este nuevo escenario

En Visionnaire, hemos seguido durante décadas

la evolución de tecnologías que, en un primer momento, parecían lejanas de la realidad de negocio, pero

que hoy forman parte del día a día de las empresas, como la propia IA. Con la Computación Cuántica

no será diferente. Más importante que “programar qubits” ahora es construir las bases para que su

organización esté preparada cuando esta tecnología entre en la fase de “uso útil”

a gran escala.

Podemos ayudar a su empresa a evaluar la madurez

en datos, IA y arquitectura de sistemas, identificando si está lista para integrar tecnologías emergentes. También

apoyamos la construcción de una hoja de ruta tecnológica realista que considere temas como criptografía

poscuántica, IA generativa, aceleración en GPU y, más adelante, integraciones con plataformas cuánticas.

Y, por supuesto, actuamos como Fábrica de Software e IA para desarrollar soluciones a medida, ya optimizadas para alto

rendimiento, simulación y algoritmos avanzados.

No necesita convertirse en especialista en Computación

Cuántica para tomar buenas decisiones hoy. Lo que sí necesita es decidir si quiere ser espectador o protagonista

en la próxima gran ola de transformación tecnológica. Si su intención es liderar, el siguiente

paso es sencillo: hablar con Visionnaire

y comenzar a diseñar, desde ahora, la estrategia que posicionará a su empresa en el mundo poscuántico.